介绍

本文认为现有的网络构建方法在学习结构和功能脑成像之间的相关性方面仍存在不足,所以提出了BrainNetDiff,结合了多头 Transformer 编码器从 fMRI 中提取相关特征,并集成了用于大脑网络构建的条件潜在扩散模型。这是第一项利用扩散技术融合多模态脑成像和脑网络构建的工作。在公共数据集ADNI上构建脑网络,并在下游任务疾病分类进行了实验。弥散张量成像(DTI)和功能磁共振成像(fMRI)已广泛应用于脑网络的构建。脑网络的节点通常被定义为给定脑图谱上的感兴趣区域(ROI),而边是根据结构脑网络的神经纤维连接的数量或从脑区域提取的血氧水平相关(BOLD)信号序列的两两相关性来计算的。与传统的基于体素的方法相比,BrainNetDiff在保持生成的大脑网络质量的同时显着提高了计算效率。此外,通过将fMRI时间序列嵌入作为条件提示并结合注意力机制,潜在空间中的结构和功能脑图像被有机地融合在一起。设计对比联合预训练来建立图像和脑网络之间的相关性。通过利用相似性特征,我们对image-graph匹配任务进行了自监督训练,其性能优于单独的自监督训练方法。

方法

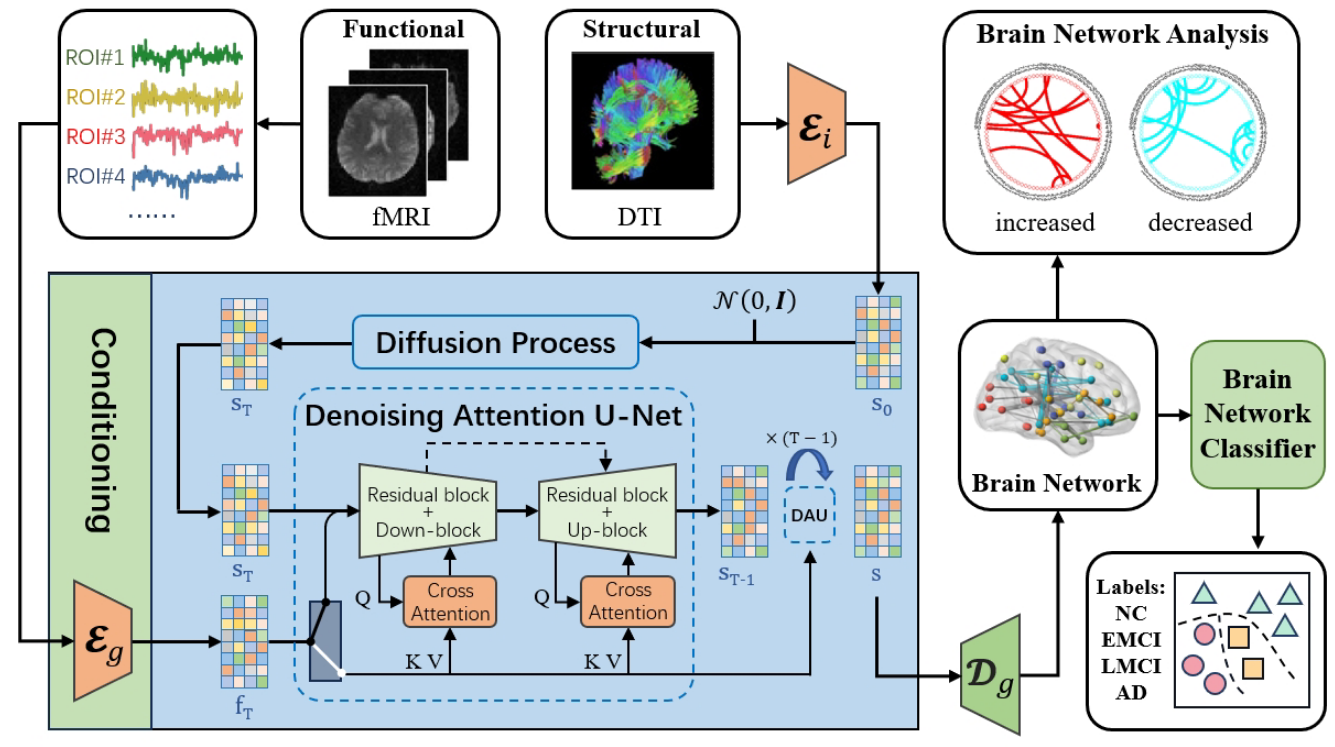

模型框架图。模型包含三个子模块:(1)image encoder 编码结构脑影像(DTI)和graph encoder 编码从功能脑影像(fMRI)中获取的ROI(2)Denoising Attention U-Net学习潜空间的脑特征(3)graph decoder生成脑网络

Conditional Latent Diffusion Model

LDM可以在低维潜在空间中对编码的图像进行去噪。前向过程包括从编码器和采样获得的,会被解码脑网络。扩散模型模拟的条件分布。利用每个样本的相应 fMRI 数据作为指导条件,这可以使用条件去噪自编码器去融合额外的疾病信息,稳定地生成脑网络。通过交叉注意力增强扩散模型的U-Net主干,这将LDM转换为更加灵活的条件图像生成器。引入特定领域编码器处理时间序列fMRI数据,将条件投影到中间表示,然后通过交叉注意力映射到U-Net中间层。损失函数:

Contrastive Image-Brain Network Pretraining

最近对图像对比表征学习的研究表明使用对比目标函数约束来学习表征优于其等效的预测目标。此外,与图像生成模型相比,等效性能对比模型需要的计算量减少了一个数量级。因此本文设计了一个更简单的替代任务,预测哪些图像对作为一个整体对应于大脑网络。通过对比脑图像和脑网络的联合预训练,将分类任务转化为Image-Graph匹配任务。使用 ResNet-50 作为图像编码的架构,并用注意力机制替换全局平均池化层。图(脑网络)编码器是一个四层地GAT自编码器,通过多注意力头增强节点表示。

Conditional Guidance

生成模型能够通过在生成过程中减少噪声输入的方差或范围来执行截断采样,从而降低样本多样性并提高生成样本的质量。本文采用分类器引导的方法来提高潜在空间的稳定性。分类器模型地对数概率的梯度近似扩散分数:

其中是控制分类器引导强度的参数。修改后的分数是从扩散模型中采样的,从分布中得到近似样本。因此,LDM的目标函数为:

分类器引导提高了数据正确标签分配的概率,导致更高置信度的引导信息对生成的大脑网络产生更强的影响,提高大脑网络生成的稳定性和准确性。分类器用于对生成的大脑网络进行多分类。分类器通过多层感知器聚合,包含丰富的病理信息的图形表示,最后与Softmax函数连接,输出每类疾病的预测概率。Dropout策略用于防止模型过度拟合。多分类损失采用多类交叉熵,类别数量为4:

总损失为重建损失与分类损失相加。

实验

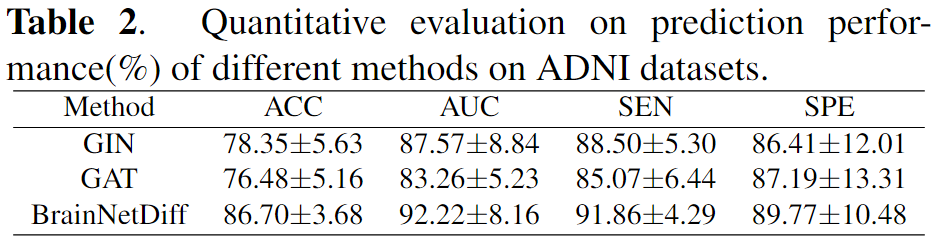

实验在20G显存的A4000显卡完成,评估指标为准确性(ACC)、敏感性(SEN)、特异性(SPE)和ROC曲线下面积(AUC)。

分类性能

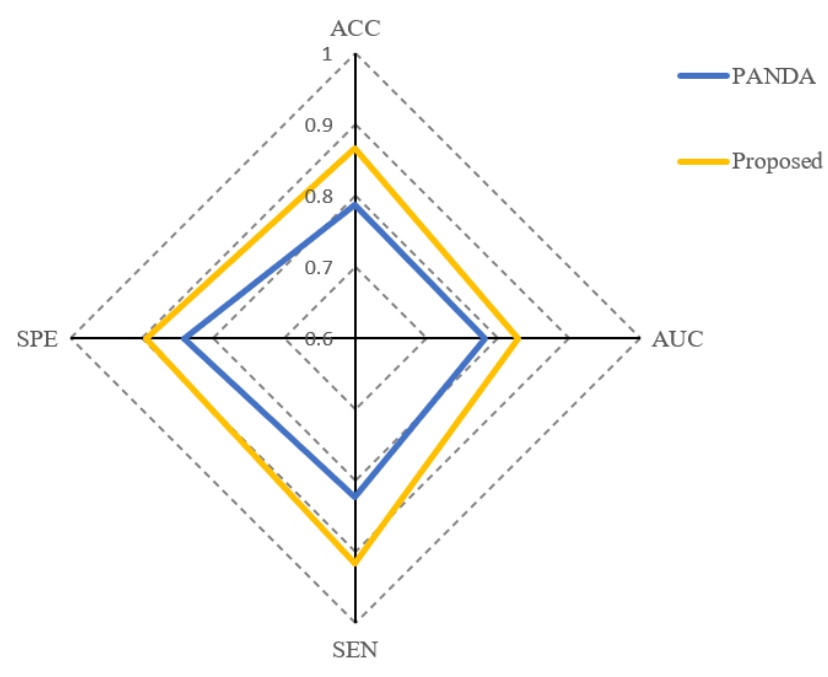

分类结果比较了GIN和GAT,传统软件PANDA。

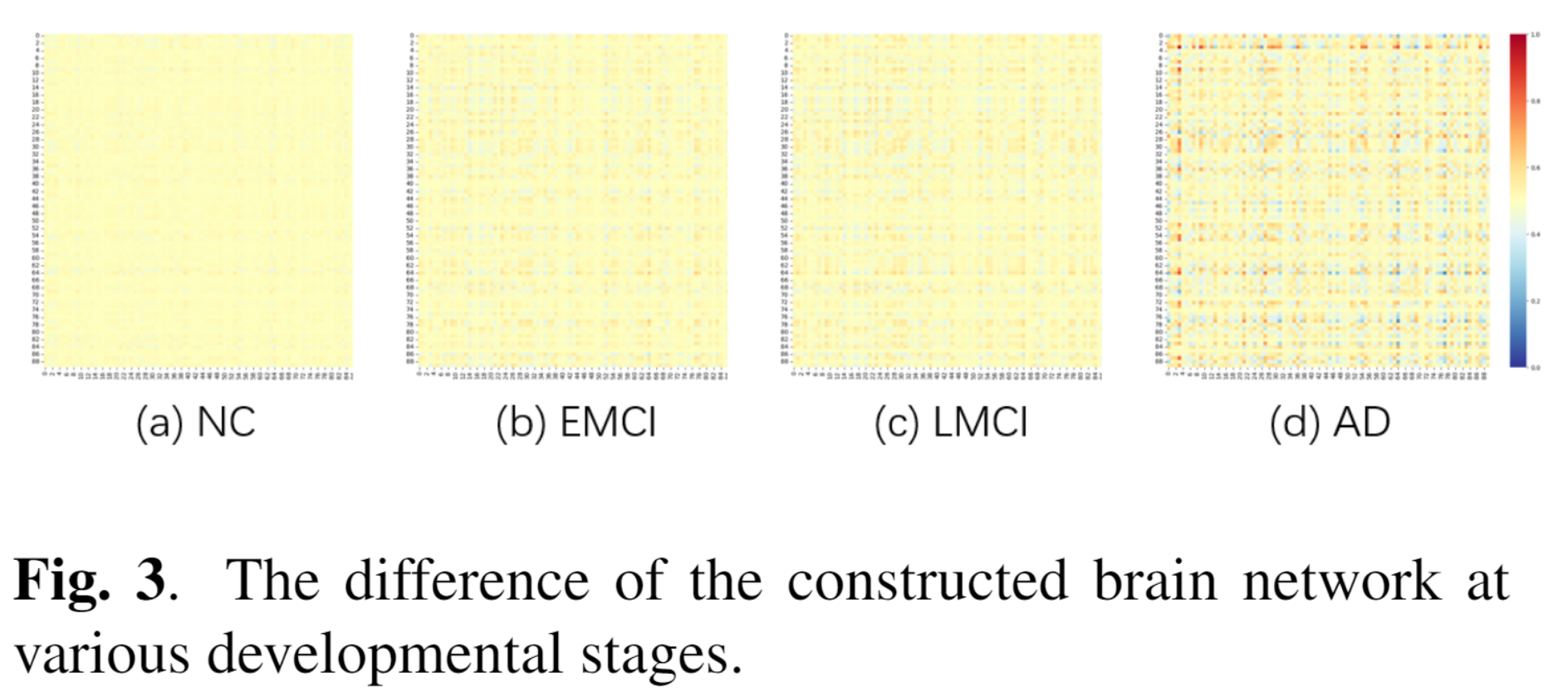

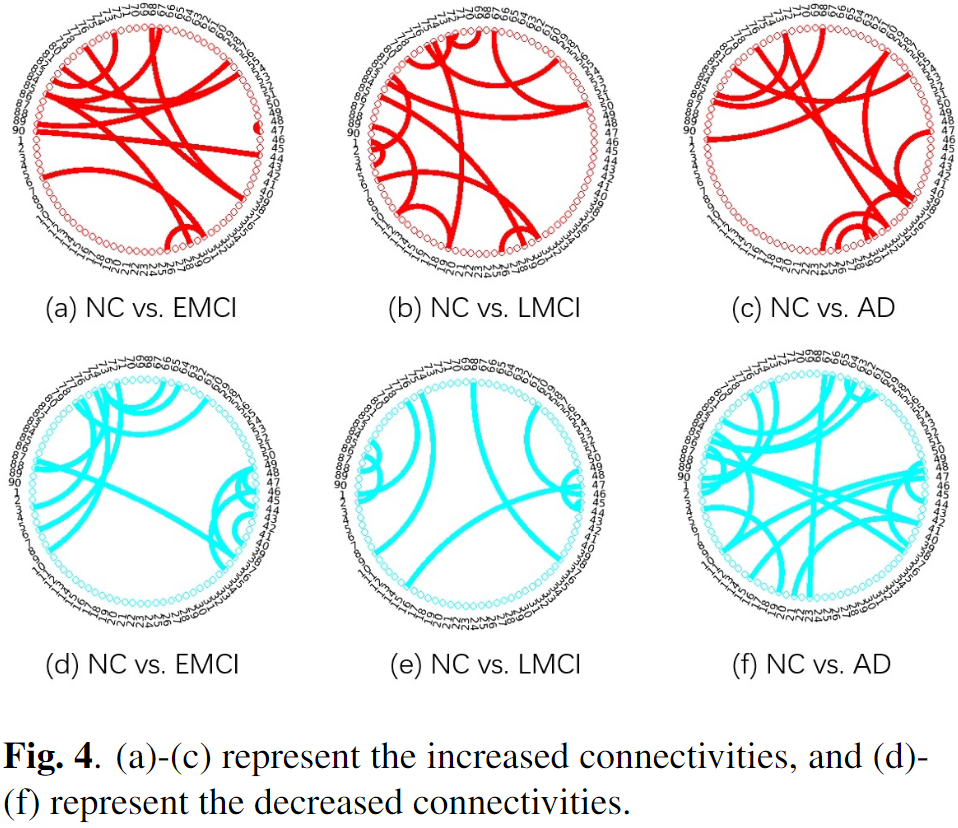

脑网络连接分析

比较了模型生成的连接矩阵与PANDA结果之间的差异。图3显示了BrainNetDiff生成的大脑网络与模板提供的参考输出之间的差异。这表明在AD(EMCI)的早期阶段,学习的大脑网络与参考大脑网络的连接矩阵是一致的,证明了我们模型的一致性。由于生成的连接矩阵引用了更多关于功能模态的信息,AD人群的大脑网络和参考模板输出之间存在显著偏差。图4比较了不同阶段大脑连接的变化。在从NC到EMCI和LMCI的疾病进展过程中,连接性增加比连接性降低更为突出。此外,阿尔茨海默病患者大脑区域之间的连通性显著降低。这些变化和趋势揭示了NC受试者向AD病理学的持续发展**:脑网络连接逐渐减少,但在早期阶段存在补偿性新连接,这与现有的神经科学研究文献一致。**